Nell'era dell'intelligenza artificiale, il vero valore non sta solo negli algoritmi, ma nei dati che li alimentano. E quando si tratta di informazioni aziendali o sensibili, dalle cartelle cliniche ai documenti finanziari, la domanda diventa cruciale: come possiamo sfruttare la potenza dell'IA senza rinunciare alla sicurezza e alla proprietà dei nostri dati? Brainyware propone un approccio diverso, "on-premise", che mette le aziende al centro e garantisce che i dati rimangano sempre sotto il loro controllo. Per scoprire come funziona e quali vantaggi concreti porta questa scelta abbiamo invitato Alberto Adorini, Co-founder e CEO di Brainyware.

Nella sezione delle notizie parliamo delle più interessanti novità presentate al CES 2026 di Las Vegas, con un focus particolare sui giochi e la robotica, tra LEGO e Boston Dynamics e della decisione di Poste Italiane di rendere lo SPID a pagamento con un canone annuale.

Immagini

• Foto copertina: Freepik

Brani

• Ecstasy by Rabbit Theft

• Time by Syn Cole

Questi modelli sono voraci di dati, cercano nuovi dati ovunque e quando gli utenti forniscono dati sulla propria azienda di fatto li stanno condividendo con il resto dell'umanità.

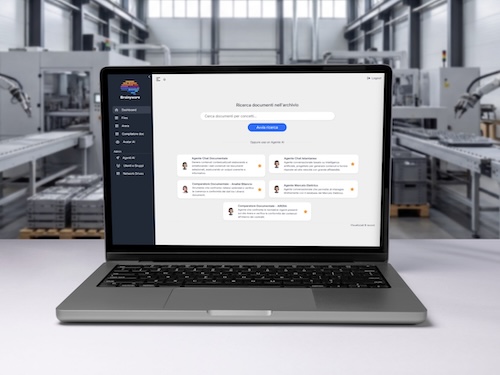

Noi risolviamo questo problema installando un hardware "on-premise", presso l'azienda, con un concetto un po' diverso rispetto a quello della chat generalista.

Dovete immaginarvelo un po' come un file system, un sistema di cartelle nelle quali ci sono i diversi file e dove la persona può interagire con la knowledge base aziendale.

Salve a tutti, siete all'ascolto di INSiDER - Dentro la Tecnologia, un podcast di Digital People e io sono il vostro host, Davide Fasoli.

Oggi parleremo con Brainyware di come le aziende possono sfruttare la potenza dell'intelligenza artificiale, senza cedere il controllo dei propri dati, attraverso soluzioni di IA "on-premise".

Prima di passare alle notizie che più ci hanno colpito questa settimana, vi ricordo che potete seguirci su Instagram a @dentrolatecnologia, iscrivervi alla newsletter e ascoltare un nuovo episodio ogni sabato mattina, su Spotify, Apple Podcast, YouTube Music oppure direttamente sul nostro sito.

Il Consumer Electronics Show 2026, tenutosi a Las Vegas questa settimana, ha confermato ancora una volta il suo ruolo di palcoscenico per le innovazioni tecnologiche più significative dell'anno appena iniziato.

Quest'anno la manifestazione ha visto proseguire con forza il trend della robotica, con aziende con cui abbiamo parlato proprio in questo podcast, come LEGO e Boston Dynamics.

Il protagonista indiscusso è stato proprio Atlas di Boston Dynamics, un robot umanoide dal peso di 90 kg, 1,9 metri di altezza e con una capacità di sollevamento di 50 kg di picco e 30 kg in uso costante.

Oltre alla nuova piattaforma elettrica che sostituisce quella idraulica, Atlas dovrà prima essere addestrato per collaborare insieme agli umani, per poi essere impiegato dal 2028 nelle linee di produzione di Hyundai per compiti di sequenziamento e assemblaggio.

E l'azienda a capo di Boston Dynamics punta a produrre 30.000 unità annue entro il 2028.

LEGO ha stupito invece con la presentazione di Smart Play, un sistema che introduce un mattoncino costituito da un minuscolo chip di appena 4,1 mm, che invece di rilevare movimento, orientamento e campi magnetici, permettendo così al mattoncino di percepire l'ambiente circostante.

Ad esempio, durante l'assemblaggio di un'astronave, quando si inserisce un mattoncino Smart Brick nel corpo della navicella e si aggiunge una Smart Minifigure di un astronauta, il mattoncino riconoscerà immediatamente che si tratta di un veicolo spaziale con equipaggio e reagirà con luci e suoni diversi durante il movimento di gioco.

Passando infine alla robotica domestica, Roborock ha svelato il Saros Rover, un aspirapolvere dotato di ruote e arti meccanici, che permettono al dispositivo di superare dislivelli e salire le scale.

Parallelamente, LG ha mostrato i progressi del suo robot CLOiD, dotato di ruote e bracci antropomorfi, pensato per le faccende domestiche.

Il cuore del sistema si basa su un'intelligenza artificiale che permette al robot non solo di eseguire compiti complessi, come prelevare cibo o gestire il bucato, ma di interpretare anche il contesto e adattarsi alle abitudini degli utenti.

Resta da capire se queste innovazioni si fermeranno alla sola sfera di prototipazione fine a se stessa o se troveranno finalmente un'utilità concreta nella nostra vita di tutti i giorni.

Da qualche anno il governo ha espresso la volontà di eliminare gradualmente lo SPID in favore della carta d'identità elettronica, ritenuta più sicura dal punto di vista tecnologico e di affidabilità dei dati, e soprattutto controllata direttamente dal ministero.

Quello dello SPID, però, è un ecosistema ormai molto integrato e difficilmente scomparirà come metodo di accesso ai servizi, sia pubblici che privati.

Tuttavia le convenzioni e i contratti pubblici con lo Stato, che coprivano i costi di gestione sostenuti dai fornitori, sono scaduti, e per questo motivo molti di loro non forniranno più il servizio SPID gratuitamente.

Tra questi, PosteID, il provider offerto da Poste Italiane, e attualmente il principale fornitore di identità digitale.

Il canone sarà di 6 euro l'anno e agli utenti coinvolti verrà chiesto il pagamento poco prima della scadenza annuale del servizio.

Saranno invece esenti dal pagamento gli over 75, i minorenni, i residenti all'estero e coloro che utilizzano il servizio per motivi professionali.

Nell'era dell'intelligenza artificiale, il vero valore non sta solo negli algoritmi, ma anche nei dati che li alimentano.

E quando si tratta di informazioni aziendali e sensibili, come ad esempio le cartelle cliniche o i documenti finanziari, la domanda diventa cruciale.

Come possiamo sfruttare la potenza dell'IA senza rinunciare alla sicurezza e alla proprietà dei nostri dati?

A tal proposito, Brainyware propone un approccio diverso, on-premise, che mette le aziende al centro e garantisce che i dati rimangano sempre sotto il loro controllo.

Per scoprire come funziona e quali vantaggi concreti porta questa scelta, è con noi Alberto Adorini, co-founder e CEO di Brainyware.

Benvenuto Alberto.

Buongiorno, grazie, grazie mille.

Chi è quindi Brainyware e in che cosa la vostra soluzione è diversa dagli altri assistenti IA che già conosciamo?

Sì, hai già toccato alcuni punti importanti, quale è quello della sovranità del dato.

Brainyware nasce per dare risposta a tutti gli elementi che bloccano l'adozione delle IA all'interno delle imprese.

E questi elementi sostanzialmente possono essere riassunti in tre punti principali.

Il primo è che, se andiamo a vedere le statistiche, 3 utenti su 4 utilizzano le IA generaliste, ChatGPT e simili, per motivi di lavoro.

Eppure non sono consapevoli del fatto che i dati che vengono caricati su queste piattaforme diventano fatalmente dei dati che servono ad allenare la prossima generazione di LLM, quindi Large Language Model.

Questo è veramente un aspetto dirimente perché questi modelli sono voraci di dati, cercano nuovi dati ovunque e quando gli utenti forniscono dati sulla propria azienda di fatto li stanno condividendo con il resto dell'umanità.

Il resto dell'umanità significa anche un loro competitor vicino, significa anche un loro competitor dall'altra parte del mondo.

Noi risolviamo questo problema installando un hardware on-premise presso l'azienda con un concetto un po' diverso rispetto a quello della Chat generalista.

Dovete immaginarvelo un po' come un file system, un sistema di cartelle nelle quali ci sono i diversi file e dove la persona può interagire con la knowledge base aziendale.

Questo dà un secondo grande vantaggio che è il fatto che le risposte che vengono date sono delle risposte che sono tarate, calzate sulla conoscenza interna aziendale.

Ora, se è vero che tante aziende... moltissime aziende B2B hanno bisogno di, per esempio, creare preventivi di vendita, è vero anche che ognuna di queste aziende quando deve creare un nuovo preventivo si basa sul proprio database storico, prende un'offerta simile, la riaggiusta, la adatta e la manda al nuovo prospect customer.

Questo secondo aspetto, se andiamo a vedere i numeri, è una parte molto importante per riuscire a garantire che gli investimenti che vengono fatti in intelligenza artificiale abbiano un ritorno sull'investimento positivo, perché è stato dimostrato

che utilizzare dell'intelligenza artificiale su dati specifici dell'azienda porta a un aumento dell'ROI nell'ordine del 30%.

Sempre collegato al tema dell'ROI c'è il terzo vantaggio di Brainyware, per come abbiamo strutturato...

E scusa, che cos'è l'ROI?

L'ROI è il ritorno sull'investimento, scusami.

È una tematica molto calda perché adesso, in questo periodo, ci sono moltissime aziende che stanno, dopo l'esperimentazione iniziale, tirando una prima riga e cercando di capire se gli investimenti che hanno fatto in "Proof of Concept", "Pilot",

prima adozione dell'intelligenza artificiale, in effetti stanno restituendo quel tipo di investimento con il rendimento e il saving che l'azienda si aspettava.

Per riuscire a calcolare un ROI tu hai bisogno sia di vedere la parte di output, abbiamo già detto come un output specifico sull'azienda sia un output migliore, che quindi dà dei risultati migliori, ma devi guardare anche la parte dei costi.

E fatalmente, quando andiamo a vedere i modelli generalisti, è praticamente impossibile riuscire a stimare qual è il costo dell'intelligenza artificiale, perché l'utilizzo dell'intelligenza artificiale si basa su due diverse componenti di costo,

una che è il costo per licenza, che è stimabile, dipende da quante persone usufruiscono dell'AI internamente all'azienda, quante licenze sei riuscito ad abilitare, ma il secondo componente è un costo per token, che è un costo variabile in base al tipo di domanda e al tipo di risposta che ricevo dall'intelligenza artificiale.

Questo costo per token non è possibile stimarlo e dipende domanda per domanda nei modelli generalisti, mentre nel nostro caso, avendo tutto lo stack tecnologico che parte dalla parte di hardware fino anche a un LLM, noi utilizziamo modelli che sono

open source oppure open weight e poi spiegherò brevemente di che cosa si tratta, il nostro strato di software, che è costruito per riuscire a "ingerire" i dati aziendali e aiutare il cliente a costruire dei casi d'uso verticali.

Ecco che questi tre elementi insieme garantiscono che è possibile avere una stima molto precisa dei costi.

Quindi miglior rendimento, costi certi, secondo noi questa è la strada giusta per riuscire a portare l'AI all'interno delle aziende italiane.

Ok, quindi anche questo è un aspetto interessante, cioè il fatto che all'inizio - soprattutto nel primo periodo dell'intelligenza artificiale generativa - c'era una corsa perché tutti dovevano implementarla, era quasi d'obbligo farlo, però

effettivamente essendo una tecnologia nuova o comunque l'approccio e l'utilizzo all'interno dell'azienda in modo così massivo era nuovo, non era possibile quantificare quali erano i costi, invece adesso si inizia un po' a tirare le somme, quindi si capisce effettivamente dove è utile oppure no, soprattutto in base al costo che ha.

E poi l'altro aspetto che ci tengo a sottolineare, anche se comunque l'hai già abbastanza raccontato, è proprio quello della sovranità del dato.

Io, anche come singolo utente al di là di un'azienda, dovrei essere un po' diffidente nel dare i miei dati, un mio documento - magari anche sensibile - a un'intelligenza artificiale, perché poi di fatto non so come questo documento verrà utilizzato in futuro.

Assolutamente così, tant'è che lungo questa direttrice stiamo vedendo tante cose diverse.

L'Europa è stata la prima a muoversi dal punto di vista della regolamentazione, ha creato l'AI Act, e l'AI Act richiede proprio che ci sia una consapevolezza di dove vengono salvati i dati e di come vengono utilizzati dall'intelligenza artificiale.

Quindi questo è un elemento molto importante, dal punto di vista regolamentare ci ha dato una mano a creare crescente consapevolezza sul mercato e sui nostri clienti.

Il secondo aspetto che mi piace sottolineare lato mercato è che noi vediamo un mercato un po' a due velocità: vediamo i player grandi che in qualche modo hanno iniziato dei programmi di trasformazione molto costosi con grosse società di consulenza

e quant'altro e sono riusciti a dare in breve tempo un'AI in mano a tutti i loro dipendenti, però questo ha lasciato fuori tutto un mercato gigante che è il mercato delle medie e piccole imprese.

Medie e piccole imprese che non hanno gli stessi strumenti tecnologici, non hanno gli stessi budget tecnologici e che quindi ancora di più si chiedono come fanno a garantire per loro stessi un ritorno sull'investimento positivo rispetto alle iniziative che fanno in ambito AI.

Sì, che non hanno gli stessi budget però forse hanno ancora più l'esigenza di integrare un'intelligenza artificiale in ciò che fanno e quindi qual è la soluzione che proponete?

Raccontaci appunto nella pratica che cosa si intende on-premise e poi concretamente che cosa fate, cioè date un server, un dispositivo hardware e lo mettete all'interno di un'azienda?

Sì, noi abbiamo dispositivi hardware di dimensioni diverse.

Abbiamo un prodotto che costa intorno agli 800 euro al mese che è il nostro prodotto di entrata e che risponde perfettamente alle esigenze dei micro business.

È un hardware esteticamente anche carino, è una cosa che metteresti volentieri sulla scrivania, è poco più grande di un vecchio computer desktop se vogliamo e questo hardware garantisce che i dati che vengono caricati sull'intelligenza artificiale rimangano sempre in locale.

Dopodiché l'altra componente è uno strato di software con il quale viene allacciata la base dati del cliente e su questa base dati è poi possibile costruire dei casi d'uso che possono partire dall'interrogazione, sintesi dei file singoli

dell'azienda ma che poi possono andare fino a delle applicazioni specifiche in modalità "low code", creando degli agenti che sono di fatto dei processi automatizzati con i quali l'intelligenza artificiale compie sempre uno stesso percorso.

Noi sappiamo che il 40% delle attività che vengono svolte da un'azienda sono attività ripetitive e se pensiamo al lavoro che ciascuno di noi fa tutti i giorni ci sono effettivamente delle cose che si ripetono con continuazione tipo una firma di un NDA, è un contratto standard dove devi compilare dei campi, sostanzialmente.

Ecco che una delle applicazioni che abbiamo generato consente la compilazione automatica di un documento partendo da delle fonti dati come carta di identità, codice fiscale.

Questa è un'applicazione che di fatto compila dei dati all'interno di un template e quindi si applica molto bene alla compilazione di un NDA ma può essere anche un contratto per l'energia elettrica, può essere un contratto finanziario e quant'altro.

Risolve quel problema che tante aziende hanno di togliere l'errore umano nel momento in cui ci sono queste tipologie di processi ripetitivi.

Ok e quindi da una parte abbiamo detto questo dispositivo hardware, fisico, e poi lo strato software, però lo strato software poi può girare su dei server che sono già presenti in azienda oppure girano in dei vostri server, che comunque rimane un sistema chiuso che contiene solo appunto i dati dell'azienda?

Sì, nel modello che ti ho spiegato per fare la parte di calcolo computazionale che è quello dove vengono processate le informazioni dell'intelligenza artificiale, viene fornita una risposta, utilizziamo il nostro data center centrale.

È possibile per i clienti che ce lo richiedono avere anche una soluzione integrata che ha sia la parte di "ingestion" dei dati che anche la parte di calcolo computazionale tutta diciamo all'interno di una stessa macchina che gli viene fornita.

In questo caso la potenza della macchina è che consente di supportare tutte le applicazioni anche di cosiddetta "edge AI", quindi intelligenza artificiale periferica sconnessa da internet, completamente offline, ma che comunque fornisce le risposte di cui ho bisogno.

Quindi potenzialmente in questa offerta si potrebbe avere anche un'intelligenza artificiale offline completamente scollegata dalla rete quindi impenetrabile da potenzialmente un attacco hacker...

Esatto.

Quindi per avere la massima sicurezza, cosa che altrimenti non sarebbe possibile utilizzando sistemi cloud ecco.

Esattamente.

Ok e in tema di potenza di calcolo?

Tu comunque ci hai detto che la maggior parte delle attività che si svolgono in un'azienda sono ripetitive e quindi immagino che non serva una potenza di calcolo enorme per fare questo tipo di attività quindi non è un problema.

No, non è un problema poi dipende chiaramente da che cosa fai, noi di cadi d'uso ne supportiamo di diversi.

Se stai nel mondo documentale... noi ci assicuriamo che la velocità con la quale forniamo le risposte sia pari o superiore ai modelli che sono disponibili come LLM generalisti.

Questo tipo di velocità viene espressa in "token per secondo" ed è per capirci la velocità con la quale l'intelligenza artificiale scrive la risposta una volta che gli ho fatto la domanda.

Un discorso leggermente diverso andrebbe fatto nel momento in cui parliamo di applicazioni che richiedono il video piuttosto che l'audio.

In quel caso lì c'è un ragionamento da fare con il cliente in termini di quanti clienti in parallelo vuole che utilizzino la soluzione per riuscire a fare un minimo di dimensionamento, ma per darti una risposta breve la parte di potenza di calcolo non è un problema ecco.

Ok ok, qualche altro esempio se vuoi farci qualche altro esempio di come può essere utilizzato... appunto quali sono altre esigenze che possono esserci?

Si, partiamo sempre dall'aspetto documentale, ne porto altri due di esempi magari.

Le aziende hanno tantissimi contratti.

Noi abbiamo visto che l'ufficio di procurement, spesso, si trova ad avere grossi problemi e processi molto ripetitivi che richiedono la conoscenza e l'andare a rivedere in continuazione i contratti di fornitura verso i clienti che sono stati creati

nel tempo per capire quali sono le clausole quando bisogna fare rinnovi, quando bisogna richiedere il monitoraggio degli SLA e quant'altro.

Questa parte può essere risolta in maniera brillante dall'intelligenza artificiale perché fornito un set di documenti è in grado di creare una tabella nella quale mi fornisce tutte le scadenze, importi economici e quant'altro.

Questo è fondamentale nel momento in cui vuoi avere una visione completa di quello che è il tuo parco fornitori e parco clienti per esempio o quando vuoi andare a vedere se ci sono degli spazi di ottimizzazione su alcune delle tue forniture.

Un altro esempio che mi viene da fare è sulla parte della gestione della manualistica.

L'Italia è il primo paese in Europa per numero di aziende che producono macchinari per il B2B.

Una cosa che non conoscono tutti, io non lo sapevo prima di affrontare questo tipo di mercato, ma è un mercato dove è necessario creare manuali.

Quindi tutta la parte di manualistica significa scrivere un manuale macchina, significa tradurre un manuale macchina se ho bisogno di tradurlo in lingue diverse o interrogare un manuale macchina.

Quindi nel momento in cui c'è un fermo macchina tipicamente si genera il panico in azienda e ci sono dei tecnici che vanno a scartabellare dei manuali che sono di centinaia di pagine o anche di più.

Ecco che l'intelligenza artificiale riesce a fare tutte e tre queste cose.

Riesce a creare un manuale macchina dato un template o vecchi esempi di manuali macchina, riesce a tradurlo mantenendo la parte di formattazione, riesce anche ad andare a ritrovare le informazioni così che nel momento in cui dovessi avere un fermo macchina per risolvere il problema ci metto mezz'ora invece che metterci 5, 6, 7, 8 ore.

E questo ha un impatto importante sulla parte di produzione.

Ok, un altro esempio che mi viene in mente, che secondo me potrebbe essere legato anche poi al tema degli obblighi di legge in materia di privacy ad esempio, quando si trattano categorie particolari di dati, dati sensibili, un sistema di questo tipo tutela maggiormente i dati dei pazienti eventualmente in ambito sanitario.

Sì, assolutamente sì, tant'è che la parte dei dati sanitari, dati finanziari, tutti i dati molto sensibili sono in realtà dei partner, dei prospect nei quali troviamo un grande interesse per la nostra soluzione.

Queste sono tipicamente società e settori che già fin dall'inizio avevano fatto fatica ad andare sul cloud e che quindi vedono nella nostra soluzione la possibilità di utilizzare l'intelligenza artificiale senza gli aspetti negativi dell'intelligenza artificiale.

Erano dei settori che sin da subito erano molto più sensibili per loro natura a queste tematiche, a differenza magari di un'azienda che produce appunto, come dicevi, degli utensili, dei macchinari, ecco.

Esattamente.

E prima accennavi a dei modelli open source e open weight che utilizzate, che cosa sono questi modelli?

Sì, guarda, spiegato in maniera molto semplice, il mondo dei large language models divide in due grandi famiglie, i modelli chiusi e i modelli aperti.

I modelli aperti sono i modelli dove anche per utilizzo commerciale è possibile utilizzare questi modelli per integrarli all'interno di altre soluzioni.

Questo significa che è possibile andare a ricostruire come il modello risponde e costruisce le domande, le risposte scusate, e quindi di conseguenza nel momento in cui faccio una domanda riesco a capire come l'intelligenza artificiale ha generato quella tipologia di risposta.

L'approccio dei modelli chiusi, viceversa, è quello di mi fai una domanda, ti do una risposta, ma non ti do visibilità su quali sono stati i... sono modelli statistici in realtà, quindi non ti do visibilità su che cosa è successo sotto il cofano e come ti ho costruito quel tipo di risposta.

Non è spiegabile.

Non è spiegabile.

Ok, e quindi dal vostro punto di vista come evolverà il settore dell'IA on-premise?

Cioè ci saranno dei limiti prestazionali, però questo mi sembra che anche questa cosa, cioè hai già detto che non ci sono tanti limiti o quasi per nulla in tema di potenza e quindi appunto quali saranno... come cambierà questo settore?

Vedremo sempre di più l'IA on-premise oppure sarà un mercato appunto bilanciato tra cloud e servizi come i vostri?

Sì, allora noi dobbiamo vedere un po' che cosa sta succedendo a livello di macro trend di mercato.

Se guardiamo a livello geopolitico c'è una corsa molto forte, una competizione molto accesa tra soprattutto Stati Uniti e Cina per vincere il predominio sulla parte del mercato dell'IA.

Tante aziende sempre di più di conseguenza o a prescindere da questo stanno abbracciando dei paradigmi di architettura ibride dove una parte delle applicazioni stanno sul cloud mentre una parte delle applicazioni, quelle che magari sono più vicine ai dati dei clienti, ai dati sensibili, al core business, vengono tenute on-premise.

Questo è un trend che per noi è sicuramente un trend positivo e molto importante.

Riuscire a portare questo tipo di soluzioni anche sui piccoli e medi business significa per noi avere una mission molto chiara che è quella di dare competitività, ridare competitività, alle micro aziende italiane che sono il sostrato, la spina dorsale della nostra economia.

Ok, va bene allora grazie Alberto perché ci hai permesso di affrontare questo tema che sicuramente è importante come dicevamo, sia in ambito aziendale soprattutto però anche per rendere chiaro appunto qual è il ruolo dei dati quando parliamo di intelligenza artificiale.

Alla prossima.

Grazie mille Davide.

E così si conclude questa puntata di INSiDER - Dentro la Tecnologia.

Io ringrazio come sempre la redazione e in special modo Matteo Gallo e Luca Martinelli che ogni sabato mattina ci permettono di pubblicare un nuovo episodio.

Per qualsiasi tipo di domanda o suggerimento scriveteci a redazione@dentrolatecnologia.it, seguiteci su Instagram a @dentrolatecnologia dove durante la settimana pubblichiamo notizie e approfondimenti.

In qualsiasi caso nella descrizione della puntata troverete tutti i nostri social.

Se trovate interessante il podcast condividetelo che per noi è un ottimo modo per crescere e non dimenticate di farci pubblicità.

Noi ci sentiamo la settimana prossima.