Il Web3, caratterizzato da app decentralizzate e basate principalmente sulla tecnologia blockchain, e il Web 3.0, o web semantico, erano le due possibili strade che il web poteva intraprendere nei prossimi decenni per diventare più accessibile anche alle macchine. Le intelligenze artificiali, però, hanno radicalmente cambiato qualsiasi modo di interagire con il web, tanto che gli stessi motori di ricerca si stanno adoperando per rispondere agli utenti in modo naturale, e non più con solo un elenco di risultati. Ha dunque ancora senso impegnarsi a ristrutturare tutto il web, quando grazie all'IA, possono essere le macchine ad evolvere e comprendere i contenuti presenti in esso?

Nella sezione delle notizie parliamo di Chrome che introduce Manifest V3 per le estensioni, di pagamenti istantanei più sicuri con Visa Protect e infine del primo atterraggio completo di Starship.

Immagini

• Foto copertina: Freepik

Brani

• Ecstasy by Rabbit Theft

• Found You by Time To Talk, Avaya & RYVM

Salve a tutti, siete all'ascolto di INSiDER - Dentro la Tecnologia, un podcast di Digital People e io sono il vostro host, Davide Fasoli.

Oggi parleremo nuovamente di Web 3.0, per cercare di capire se lo sviluppo dei grandi modelli di intelligenza artificiale, come ChatGPT o Gemini, ha posto la parola fine al sogno di Tim Berners-Lee di creare un web semantico.

Prima di passare alle notizie che più ci hanno colpito questa settimana, vi ricordo che potete seguirci su Instagram a @dentrolatecnologia, iscrivervi alla newsletter e ascoltare un nuovo episodio ogni sabato mattina, su Spotify, Apple Podcast, YouTube Music oppure direttamente sul nostro sito.

Nel 2019 Google iniziò ufficialmente la transizione da Manifest V2 a Manifest V3, transizione che dopo numerosi rinvii e rivisitazioni ha infine rilasciato lo scorso 3 giugno nella versione beta del suo browser Chrome.

Ciò significa che nei prossimi mesi Manifest V3 sbarcherà anche nella versione finale, e dopo un primo periodo in cui Manifest V2 resterà retrocompatibile, la nuova versione sarà l'unica disponibile.

Ma che cos'è Manifest e perché ha suscitato diverse polemiche negli ultimi tempi?

In sostanza riguarda le estensioni che vengono installate nel browser e i loro permessi.

Attualmente, infatti, le estensioni hanno accesso pressoché completo a qualsiasi elemento della pagina e alle richieste web.

Con Manifest V3, invece, Google cerca di porre delle restrizioni, come differenti API o il divieto di ospitare codice in remoto.

La motivazione è che, con Manifest V3, il browser offre una maggior sicurezza agli utenti, più privacy e maggiori performance.

Tuttavia, molte estensioni, come gli AdBlocker, non potrebbero più funzionare con la V3, e da qui le polemiche.

Sembra, infatti, che questa sia l'ennesima mossa di Google per limitare gli AdBlocker e di fatto proteggere i suoi interessi.

Nel corso degli anni, fortunatamente, Google ha reso Manifest V3 meno restrittivo, per venire incontro agli sviluppatori e alla community.

Il rischio, infatti, è che, se gli AdBlocker non fossero più utilizzabili, Google perderebbe migliaia di utenti, già pronti a cambiare browser.

Visa ha lanciato un progetto basato sull'intelligenza artificiale per migliorare la sicurezza dei pagamenti istantanei, rispondendo all'aumento delle frodi segnalato dalla Autorità bancaria europea e dallo European Payments Council.

Un progetto pilota nel Regno Unito ha dimostrato, infatti, che la tecnologia di AI di Visa può identificare il 50% delle transazioni fraudolente che sfuggono ai sistemi bancari, riducendo drasticamente le perdite annuali di 600 milioni di sterline.

In Italia, Visa ha introdotto Visa Protect for A2A Payments, che rileva le fraudi in tempo reale e blocca le transazioni sospette prima che il denaro esca dai conti.

Stefano Stoppani, di Visa, ha sottolineato l'importanza di garantire la sicurezza dei pagamenti istantanei e ha evidenziato i successi dell'azienda nel ridurre le fraudi ai minimi storici.

La tecnologia AI di Visa protegge consumatori e imprese, mantenendo la fiducia nei pagamenti digitali.

Dopo il quarto lancio sperimentale, il razzo Starship dell'Agenzia Spaziale SpaceX è riuscito a tornare integro sulla Terra, sia con il booster Super Heavy che con la navicella madre.

Il test, che è avvenuto giovedì 6 giugno, è stato perciò un successo senza precedenti, che ha reso Starship ancora più vicino al lancio con umani.

SpaceX sta lavorando a questo progetto ormai da una decina di anni, col obiettivo di sviluppare un sistema di lancio multiuso, che potrà essere impiegato dalla stessa compagnia, sia per lanciare più Satelliti Starlink al posto dei Falcon 9, ma anche dalla NASA per portare astronauti sulla Luna e su Marte.

Come per i test precedenti, con l'ultimo lancio, SpaceX non intendeva recuperare i due stadi, ma puntava più che altro a farli ammarare simulando comunque un rientro controllato sulla terraferma.

Anche perché, come dimostrato dal tentativo di giovedì, il rientro in atmosfera rimane ancora parecchio traumatico per la navicella madre, tant'è che durante la discesa diverse componenti legati agli scudi termici sono state disintegrate, perciò con il prossimo tentativo sarà fondamentale ottimizzare ulteriormente la gestione del rientro.

Poco più di un anno fa abbiamo trattato in una puntata delle due possibili strade che il web potrà percorrere nei prossimi anni o decenni, vedendo come in realtà entrambe quelle tecnologie siano percorribili indipendentemente, potendo tranquillamente coesistere per dare una nuova forma all'internet che conosciamo.

Stiamo parlando del Web3, caratterizzato da app decentralizzate e basate principalmente sulla tecnologia blockchain, e del Web 3.0, o Web semantico.

E in questa puntata lasceremo da parte il Web3, per concentrarci invece sul Web 3.0 e capire se e come questo approccio è cambiato con l'avvento dei Large Language Model, o se di fatto per colpa dell'intelligenza artificiale questo concetto sia superato.

Innanzitutto iniziamo spiegando o ricordando che cos'è il Web 3.0.

Il 6 agosto del 1991 Tim Berners-Lee, il padre del World Wide Web, pubblicò il primo sito web al mondo, in questo primo periodo si parla di Web 1.0, caratterizzato da pagine statiche e puramente informative con testi, immagini, presentazioni e così via.

All'aumentare della potenza di calcolo, alla nascita di nuovi linguaggi di programmazione specifici per i server e all'introduzione di nuove versioni di HTML, CSS e JavaScript - i tre linguaggi principali che vengono utilizzati per realizzare pagine

web - i siti diventano sempre più complessi e dinamici, e da qui si inizia a parlare di Web 2.0, termine coniato ad ottobre del 2004 dall'editore Tim O'Reilly.

Il Web 2.0 è quello che tutti noi conosciamo, e che quotidianamente usiamo, formato da vere e proprie applicazioni web, social network, wiki e molto altro.

Un'evoluzione che per certi versi è andata nel verso opposto ai sogni e alle visioni di Tim Berners-Lee.

E quale miglior modo per spiegare la sua visione se non citando direttamente uno dei suoi discorsi che recitava: "Ho un sogno riguardo al web, ed è un sogno diviso in due parti.

Nella prima parte, il web diventa un mezzo di gran lunga più potente per favorire la collaborazione tra i popoli".

E fino a qui possiamo dire che il sogno di Tim Berners-Lee si è ampiamente realizzato.

Ad oggi il web è uno spazio pubblico e democratico, che permette di condividere e collaborare, ma anche creare informazioni e di unire persone da parti del mondo totalmente opposte.

Chiaramente, tenendo conto anche dei pericoli di questa, tra virgolette, democrazia, quasi priva di regole di cui tante volte abbiamo parlato.

Ma il sogno è diviso in due parti, e Tim Berners-Lee prosegue dicendo: "Nella seconda parte del sogno la collaborazione si allarga ai computer.

Le macchine diventano capaci di analizzare tutti i dati sul web, il contenuto, i link e le transazioni tra persone e computer.

La rete semantica, che dovrebbe renderlo possibile, deve ancora nascere, ma quando l'avremo i meccanismi quotidiani di commercio, burocrazia e vita, saranno gestiti da macchine che parleranno a macchine, lasciando che gli uomini pensino soltanto a fornire l'ispirazione e l'intuito.

Finalmente si materializzeranno quegli agenti intelligenti sognati per decenni".

Ed è proprio qui che arriviamo al Web 3.0, dove la parola chiave è quella di rete semantica citata dal padre del web.

Attualmente, infatti, le pagine web sono dei semplici contenuti testuali, certo abbelliti con diversi stili e arricchiti di immagini ed altri elementi, ma la maggior parte delle informazioni contenute online è formata da testi, collegati tra loro tramite link.

E se per un essere umano un testo è perfettamente comprensibile e ricco di informazioni, una macchina ci vede solo un susseguirsi di caratteri senza significato.

Nel Web semantico, invece, come suggerisce il nome, i contenuti acquisiscono delle informazioni che rendono il testo comprensibile anche ad una macchina.

In particolare, vengono utilizzate delle "triple" formate da soggetto, predicato e oggetto.

Ad esempio, nella frase Tim Berners-Lee ha inventato il World Wide Web, abbiamo il soggetto Tim Berners-Lee, un predicato che indica una sua invenzione, e l'oggetto il World Wide Web.

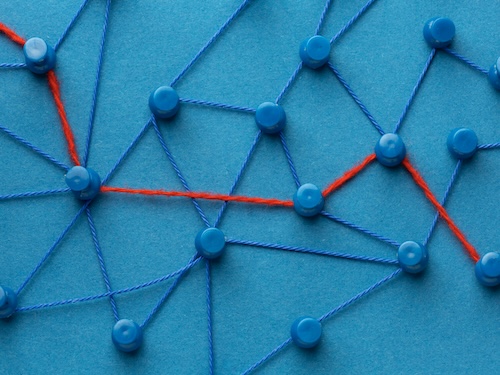

Oggetto che a sua volta può essere correlato con la data di nascita, collegata a sua volta da altre venti e così via, fino a formare un enorme grafo di conoscenza potenzialmente di tutto il mondo, e proprio per questo motivo si chiama "Knowledge Graph", o "Linked Open Data".

Il più grande Knowledge Graph pubblico, al momento, è "DBpedia", con più di 228 milioni di entità presenti.

Tuttavia, il Web semantico non ha mai preso troppo piede.

Se per le macchine, infatti, era più facile comprendere il significato dei testi, per l'uomo diventa molto più difficile leggere e inserire dati strutturati e non in una forma di comunicazione naturale, a cui siamo abituati.

Per questo, la semantica può essere integrata direttamente nella pagina web, definendo degli attributi specifici ai vari elementi o inserendo particolari tag con all'interno, invisibili all'utente, i dati sul formato strutturato.

Da questo punto di vista, motori di ricerca come Google stanno spingendo molto verso questa direzione per riuscire a fornire informazioni precise alle domande che vengono poste o identificare al meglio i contenuti.

E i risultati di questa strada che il Web sta percorrendo li notiamo, ad esempio, quando effettuiamo una ricerca, dove sono presenti delle card specifiche, ad esempio per ricette o prodotti, con informazioni extra che vengono inserite nella pagina in modo strutturato.

Un altro esempio sono le card di Wikipedia, che spesso vediamo al lato della pagina, dove vengono indicati come tabella alcuni dati principali di un personaggio, un evento o di una qualsiasi entità.

Ma veniamo ora al punto cruciale della puntata, che abbiamo introdotto all'inizio, ossia il Large Language Model, gli algoritmi di intelligenza artificiale in grado di, tra virgolette, "comprendere e generare" testo come gli ormai famosissimi ChatGPT, Gemini o Lama.

Queste intelligenze artificiali, infatti, hanno radicalmente cambiato qualsiasi modo di interagire con il web, tanto che gli stessi motori di ricerca si stanno adoperando per rispondere agli utenti in modo naturale, e non più solo con un elenco di risultati.

E nel contesto del web semantico, sognato da Tim Berners-Lee, viene da chiedersi se questo sogno, che, come abbiamo visto, pian piano si sta cercando di costruire, non sia completamente abbandonato in favore di tecnologie più avanzate.

Non a caso, ognuno di noi ha sicuramente provato, almeno una volta, ad utilizzare ChatGPT o Bing per ottenere delle risposte rapide su un certo argomento, o magari per creare un riassunto, fare domande riguardanti un documento allegato o altro ancora.

E almeno in apparenza sembra proprio che questi enormi modelli di intelligenza artificiale abbiano veramente compreso il testo che noi abbiamo inserito e siano stati in grado di fornire risposte più o meno accurate al quesito posto.

Tuttavia, non funziona veramente così.

Le IA generative non hanno coscienza di ciò che stanno scrivendo, semplicemente accostano ad una serie di parole, token per la precisione, la parola che ritengono più probabile in quell'istante.

Per questo motivo si parla molto spesso del problema delle allucinazioni, ossia quei fenomeni in cui l'intelligenza artificiale inventa delle informazioni o risponde in modo del tutto casuale.

Ciò che importa al modello è di fornire una risposta sensata, senza badare al fatto che ciò che ha prodotto sia vero o no.

Ciò che veramente conta al momento, però, è che nella stragrande maggioranza dei casi, non si sa in che modo, li risponde veramente bene e porta al termine egregiamente il compito richiesto.

A questo punto, dunque, a cosa serve impegnarsi ad adattare il web e renderlo comprensibile dalle macchine quando grazie all'intelligenza artificiale possono essere le macchine ad evolvere e comprendere il web?

Se in futuro l'IA sarà ancora più potente e sia l'hardware che il software saranno sempre più ottimizzati per eseguire il large language model, occupando meno risorse ed energia, direzione verso cui stiamo andando, di fatto risulta molto più

conveniente affidarsi completamente alle macchine per far comprendere a loro un testo, per noi naturale, sperando però che il modello risponda sempre correttamente.

Ma la probabilità può funzionare in certi contesti, magari più creativi e obbistici.

Ma in un ambiente professionale?

Può ad esempio un avvocato o un medico o un ingegnere permettersi di sfruttare l'intelligenza artificiale per, di fatto, lavorare al suo posto senza le dovute accortezze?

O può un'azienda fornire un servizio legato all'intelligenza artificiale in ambiti in cui la precisione è estremamente fondamentale?

Chiaramente la risposta a questa domanda è no.

Ed è per questo che in certi contesti l'uso dell'IA può certamente aiutare nel proprio lavoro, ma non potrà al momento sostituirlo.

E proprio in questo momento capiamo che forse i Large Language Model non sono destinati a sostituire o frenare il sogno di Tim Berners-Lee verso il Web 3.0, quanto più a collaborare per ottenere il meglio l'uno dall'altro.

Facciamo un esempio più pratico: capita spesso ultimamente che si senta parlare di auto a guida autonoma e di come non siano ancora pronte per essere utilizzate su larga scala.

Le intelligenze artificiali di queste auto, infatti, sono state addestrate per riuscire ad adattarsi ad un ambiente costruito a misura d'uomo e per questo è difficilissimo riuscire a coprire tutte le possibili casistiche che si possono presentare nell'arco di una guida.

Pensiamo anche banalmente a un cartello stradale sbiadito o poco visibile, dei comportamenti imprevedibili dei pedoni e così via.

Ma la situazione sarebbe decisamente diversa se al contrario investissimo per adattare le strade alle auto, magari utilizzando tecnologie come i beacon in grado di comunicare automaticamente la presenza di determinati cartelli stradali o di specifiche variazioni.

Le auto in questo modo avrebbero una accuratezza decisamente maggiore, risultando più sicure nelle scelte e facendo quindi meno affidamento sulla probabilità.

Per il web e l'intelligenza artificiale generativa sarebbe di fatto lo stesso.

Costruire un web a misura non solo d'uomo ma anche per i computer permetterebbe all'intelligenza artificiale di comprendere le domande degli utenti, recuperare le informazioni da un immenso grafo interconnesso.

Quindi un grafo che toccherebbe tutti gli ambiti della conoscenza umana, aggiornato e mantenuto da esperti dei vari settori, un po come accade per Wikipedia.

Una volta ottenute queste informazioni, il modello linguistico può tranquillamente rispondere all'utente con dati precisi e corretti, pur mantenendo un'interazione più naturale.

Sia chiaro, questo schema di funzionamento viene già utilizzato e prende il nome di Retrieval Augmented Generation, RAG, in cui appunto il software, prima di rispondere, cerca i dati più rilevanti da utilizzare per generare una risposta.

Dati che si possono trovare ad esempio nel PDF caricato o nelle pagine web dei risultati di ricerca.

Tuttavia, parliamo sempre di testo scritto che il modello deve in qualche modo comprendere per fornire una risposta, che comunque, può essere soggetto ad allucinazioni.

Ma non è finita qui, la tra virgolette "collaborazione" può infatti avvenire anche al contrario in questo caso.

Si potrebbe in pratica sfruttare l'IA per generare dati strutturati partendo da un testo scritto, riducendo il carico di lavoro umano per passare dal web 2.0 al web 3.0.

Rendendo il sogno di Tim Berners-Lee - di creare un web inclusivo per umani e macchine - non solo più attivo che mai, ma ancora più vicino dall'essere realizzato.

E così si conclude questa puntata di INSiDER - Dentro la Tecnologia, io ringrazio come sempre la redazione e in special modo Matteo Gallo e Luca Martinelli che ogni sabato mattina ci permettono di pubblicare un nuovo episodio.

Per qualsiasi tipo di domanda o suggerimento scriveteci a redazione@dentrolatecnologia.it, seguiteci su Instagram a @dentrolatecnologia dove durante la settimana pubblichiamo notizie e approfondimenti.

In qualsiasi caso nella descrizione della puntata troverete tutti i nostri social.

Se trovate interessante il podcast condividetelo che per noi è un ottimo modo per crescere e non dimenticate di farci pubblicità.

Noi ci sentiamo la settimana prossima.